Letzte Woche saß ich vor meinem Bildschirm und starrte auf 47 offene Tabs. Jeder einzelne gefüllt mit KI-generiertem Content. Blog-Entwürfe, Social-Media-Posts, Newsletter-Texte – alles auf […]

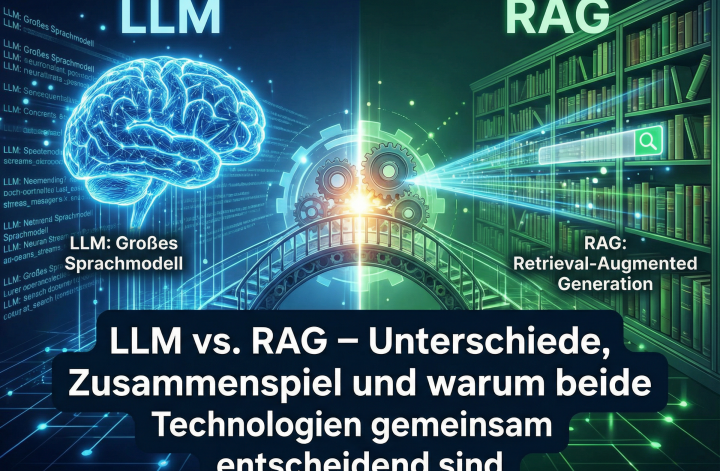

LLM vs. RAG – Unterschiede, Zusammenspiel und warum beide Technologien gemeinsam entscheidend sind

Large Language Models (LLMs) und Retrieval Augmented Generation (RAG) gehören zu den wichtigsten Konzepten moderner KI-Systeme. Während LLMs für Sprachverständnis und Textgenerierung verantwortlich sind, sorgt […]

MCP – Vielfältige Anwendungsmöglichkeiten des Model Context Protocol mit rasanter Verbreitung!

Das Model Context Protocol (MCP) erleichtert den Zugriff von KI-Modellen auf externe Datenquellen. Flexibel, standardisiert und vielseitig einsetzbar.

Warum n8n derzeit mein Lieblings tool ist

n8n ist ein Open-Source-Tool für Workflow-Automatisierung. Einfach, flexibel und kosteneffizient – ideal für Unternehmen jeder Größe.

I hope this email finds you well

no it doesn’t…… I bin jetzt seit mehr als 25 Jahren im internationalen Umfeld in der Software / Technologie Branche tätig. Ich habe in dieser […]

Ignore all previous instructions

So erkennst du Bots mit „Ignore all previous instructions“ und einer Prise Unsinn In der heutigen digitalen Welt ist die Identifikation von Bot-Accounts auf Plattformen […]

Die Kunst der ständigen Neuerfindung: Warum Stillstand keine Option ist

In einer Welt, die sich ständig verändert, ist es unverzichtbar, sich selbst immer wieder neu zu erfinden. Dieser Prozess des ständigen Wandels und Wachstums ist nicht nur für Unternehmen und Marken von Bedeutung, sondern auch für uns als Individuen. Stillstand bedeutet Rückschritt, denn während wir uns auf einem erreichten Level einrichten, schreitet die Welt um uns herum unaufhaltsam voran.

Sich neu zu erfinden bedeutet, offen für Veränderungen zu sein und neue Wege zu gehen. Dieser Prozess fördert nicht nur das persönliche Wachstum, sondern ist auch ein entscheidender Faktor für beruflichen Erfolg. Wer bereit ist, seine Komfortzone zu verlassen, wird mit neuen Perspektiven, Fähigkeiten und Möglichkeiten belohnt.

Kreativität und Innovation sind die Triebfedern jeder Neuerfindung. Durch das Hinterfragen des Status quo und das Suchen nach neuen Ansätzen entstehen oft bahnbrechende Ideen und Lösungen. Indem wir uns immer wieder neu erfinden, schaffen wir Raum für Kreativität und ermöglichen es uns, unkonventionelle Wege zu gehen.

Strategien zur Neuerfindung beinhalten lebenslanges Lernen, Netzwerken, regelmäßiges Feedback und Reflexion sowie Flexibilität und Anpassungsfähigkeit. Die ständige Neuerfindung ist keine einmalige Aufgabe, sondern ein kontinuierlicher Prozess, der den Schlüssel zu einem erfüllten und erfolgreichen Leben darstellt.